Circa un anno e mezzo fa, quando ci fu il boom dell’intelligenza artificiale, ormai conosciuta da un pubblico più che ampio, scrissi un articolo dal titolo “Le AI sostituiranno completamente gli artisti?“. Beh, a giudicare da come vengono generati alcuni dettagli delle figure umane, in particolar modo le mani, direi che la risposta è ancora no.

Ormai l’utilizzo dell’AI, sia per lavoro che per svago, ha guadagnato una rilevanza enorme, soprattutto in questo 2024. Ciononostante, spesso questa tecnologia si perde in dettagli apparentemente semplici, come il disegnare le mani. In questo articolo analizziamo l’evoluzione dell’AI nell’ultimo anno e mezzo ed i motivi del perché continui ancora a scontrarsi con questi aspetti.

L’evoluzione dell’intelligenza artificiale

Nell’ultimo biennio, l’intelligenza artificiale generativa ha fatto passi da gigante. Ciò che una volta era un’applicazione di nicchia e altamente tecnica è diventata accessibile praticamente a tutti. Ormai chiunque può accedere a ChatGPT o Midjourney e creare codice, contenuti o persino arte.

La generazione di immagini attraverso l’AI rimane senza dubbio uno dei tratti più affascinanti (e discussi) di questa tecnologia. Lasciando da parte i discorsi prettamente etici o morali, resta incredibile il fatto che generatori come Midjourney possano trasformare poche righe di testo in immagini complesse o addirittura opere d’arte realistiche.

I modelli di intelligenza artificiale utilizzano una tecnologia chiamata “Deep Learning”, che permette loro di migliorare anche dai propri errori, generando risultati sempre più realistici. Vediamo infatti come cambia l’output di un’immagine con lo stesso comando, dato rispettivamente un anno e mezzo fa ed oggi.

I diversi output dello stesso prompt a dicembre 2022 e giugno 2024

Possiamo notare facilmente come la qualità ed il realismo delle immagini siano notevolmente cresciuti. Nell’immagine di dicembre 2022, i colori sono molto accesi, poco realistici; l’acqua sembra quasi ferma e filiforme, le ombre sono poco accennate. Nell’immagine appena generata invece, le luci sono estremamente verosimili; ci sono zone a fuoco e zone fuori fuoco, in maniera intenzionale; l‘acqua ha riflessi realistici e la cascata dà un senso di movimento che si avvicina moltissimo a quella di un flusso d’acqua reale. Ma vediamo un altro esempio.

Anche in questo confronto, si possono notare i miglioramenti nell’output del 2024

Il migliorato realismo si nota ancora di più in questo confronto. La foto generata a dicembre 2022 ha nuovamente un tono piatto, la neve è (troppo) perfetta, i mattoni di cui è composta la casa sono strani, come anche il numero e la posizione di porte e finestre. Gli alberi sono poco realistici e sembrano quasi fondersi con il tetto della casa. La foto dovrebbe essere “scattata” durante una tempesta di neve, eppure si notano solo alcuni fiocchi davanti all’albero di sinistra. Viceversa, la foto più recente presenta un miglior bilanciamento dei colori ed un realismo generale più marcato. La casa non presenta anomalie ed è perfettamente realistica eccezion fatta forse per quel “serpentone” di neve ai piedi del camino. Gli alberi ed il fogliame, sia in primo piano, che sullo sfondo, sono difficilmente distinguibili da quelli veri.

Non possiamo negare, quindi, i grandi progressi che l’AI ha fatto in termini di generazione di immagini realistiche. Ma nonostante le incredibili capacità dei generatori di immagini basati sull’AI, c’è ancora un’area importante in cui faticano: la creazione di persone realistiche. Questi strumenti, infatti, non sembrano ancora in grado di produrre rappresentazioni realistiche di mani, denti e occhi umani, per ragioni che approfondiremo più avanti. I risultati possono essere divertenti, ma anche decisamente inquietanti.

Le parti del corpo che le AI sbagliano più spesso

Tra tutte le caratteristiche umane che i generatori di immagini non riescono a riprodurre correttamente, ce ne sono tre che spiccano in particolare. Analizziamo ognuna di esse ed esaminiamo perché sono così difficili da replicare in maniera fedele.

Le mani create dall’AI

Disegnare le mani resta, a quanto sembra, la cosa più difficile per l’AI. Spesso le mani presentano infatti pose innaturali o uno strano numero di dita (solitamente più di cinque). Questo resta quindi uno dei criteri principali che ci permette di stabilire se un’immagine è stata generata artificialmente o meno. Controlla sempre le mani: ci sono troppe dita? Le mani non sono proporzionate alla figura? Le dita presentano pieghe strane o innaturali?

Guardiamo queste due immagini. Ho chiesto a Midjourney un’immagine di una donna che stringe in mano una penne. Ecco due dei risultati:

Dobbiamo ammettere che i risultati sono straordinariamente realistici, perlomeno se guardiamo i tratti del viso delle due donne, i capelli, il vestito di lana della seconda immagine. Le mani, però, presentano qualche problema. Le mani della prima donna non sembrano particolarmente realistiche nella texture della pelle: appaiono inverosimilmente troppo lisce, senza pieghe e forse anche eccessivamente lunghe. Nella seconda immagine, poi, possiamo notare che sono presenti solo quattro dita. Inoltre, le mani non svolgono la funzione richiesta: infatti non stringono la penna, che invece fluttua nel vuoto davanti al viso della ragazza. Sembra proprio che l’AI faccia fatica a disegnare mani che compiono un’azione, come appunto afferrare un oggetto o, peggio ancora, stringersi tra di loro. Ecco infatti il secondo esempio di un prompt relativo a due mani con smalto rosso che si stringono l’una con l’altra.

Anche in questo caso, ci sono diverse cose che lasciano perplessi. Nella prima foto, abbiamo una sorta di “doppio dito” a due estremità, con tanto di duplice unghia. In questo caso alcune dita sono coperte, ma ad una prima occhiata sembra che non siano esattamente dieci. I polsi, inoltre, presentano una postura piuttosto innaturale. Non va meglio con la seconda foto, dove notiamo un intreccio di dita che lascia più di un dubbio. La texture della pelle è buona, ma anche in questo caso il numero di dita non sembra nella norma. C’è poi un anello, anche qui fluttuante e non infilato su di un dito.

Insomma, se ad uno sguardo veloce il realismo delle mani – dato dalla pelle, dalla luce, e dai dettagli cromatici – può trarci in inganno, osservando più attentamente potremo notare diversi dettagli che ci porteranno senza dubbi alla conclusione che queste immagini sono state generate da un’AI. A questo punto, però, sorge spontaneo chiederci: perché tutta questa difficoltà nel riprodurre fedelmente le mani?

Perché le AI non riescono a disegnare bene le mani

Le ragioni per cui questi strumenti non sembrano in grado di riprodurre il normale aspetto delle mani sono in realtà un esempio lampante dei limiti dell’AI.

Il primo grande motivo è che l’intelligenza artificiale non è umana. Per quanto banale e scontata possa apparire questa affermazione, è probabilmente la spiegazione principale di questi errori di generazione. Le AI, infatti, sono addestrate su un set di dati di milioni di immagini, ma non hanno necessariamente una comprensione di cosa sia effettivamente una mano. L’AI non sa che le mani dovrebbero avere quattro dita e un pollice, o le proporzioni generali di dita e palmi. Inoltre, non può comprendere l’anatomia dei movimenti delle mani, né come si piegano propriamente i polsi, le dita e le falangi. Un artista umano può guardare la propria mano, o la mano del modello, da qualsiasi angolazione e posizione, prendendosi il tempo per capire come cambiano, come si piegano e quali movimenti possono fare. L’AI sa solo ciò che ha imparato dalle immagini statiche nel suo set di dati, che poi combina per creare una nuova immagine.

C’è poi un ulteriore problema. Questi generatori non hanno acquisito informazioni sufficienti sulle mani per riprodurle fedelmente. Non solo il numero di fotografie di mani è relativamente piccolo rispetto ai milioni di altre immagini analizzate, ma spesso queste hanno anche angolazioni diverse, il che rende più difficile per l’intelligenza artificiale comprendere le diverse posizioni, la profondità ed i movimenti. Probabilmente, addestrando un’AI con esclusivamente immagini di mani (parliamo comunque di milioni), i risultati sarebbero migliori, ma l’AI funziona attualmente con campioni di dati più ampi.

Infine, c’è anche il giudizio umano. Quando l’AI genera un’immagine sbagliata di una mano, ce ne accorgiamo subito perché abbiamo trascorso tutta la nostra vita osservando le nostre mani e le mani di altre persone. Sappiamo come sono, come si muovono e come non si muovono. Al contrario, quando l’AI si prende delle libertà con, ad esempio, i rami di un albero, oppure la trama di un tessuto, è meno probabile che ce ne accorgiamo.

I denti nell’AI

Un altro aspetto controverso dell’anatomia umana con cui le AI hanno un rapporto difficile riguarda i denti.

Nelle immagini generate che vediamo in alto, molti dei denti sembrano inquietanti. Ci sono troppi denti in ogni bocca e sono troppo luminosi e prominenti.

Nella prima foto, il sorriso della donna al centro ha qualcosa di strano, i denti sembrano avere tutti la stessa dimensione e si nota anche la mancanza dell’arcata inferiore. La ragazza alla sua sinistra, poi ha dei denti estremamente sporgenti con la gengiva inverosimilmente troppo esposta. Nella foto a destra, il realismo è sicuramente maggiore ma anche in questo caso, i denti sembrano decisamente troppi e troppo uguali; anche in questo caso, spesso l’AI si perde l’arcata inferiore.

I motivi per cui i generatori di immagini IA sbagliano quando si tratta di denti sono simili ai motivi per cui non riescono a disegnare bene le mani. L’AI è in grado di capire che i denti sono bianchi, lucidi e disposti in file, ma non sa esattamente quanti denti abbia una persona media.

Gli occhi nell’AI

Le parti del corpo con cui l’AI sembra avere meno problemi sono sicuramente gli occhi. Anche questi non sono esenti da imprecisioni e stranezze ma, nel complesso, paragonate a mani e denti, risultano in media molto più realistici.

Le immagini in alto sicuramente fanno impallidire le varie mani con quattro dita o i sorrisi a quaranta denti degli esempi precedenti. Il realismo è incredibile in molti dettagli del viso, come le lentiggini, i capelli, le labbra ecc. Anche gli stessi occhi sono estremamente realistici ed espressivi. Tuttavia, ad uno sguardo un po’ più attento, anche in questi due esempi possiamo trovare delle piccole imperfezioni.

Nella prima immagine manca la pupilla, che assume una strana forma ovale e verticale, quasi come quella di un serpente. Le proporzioni sono buone, come anche i dettagli del trucco e del mascara. La seconda immagine non ha niente di particolarmente sbagliato. Forse anche in questo caso una pupilla non propriamente definita nei contorni, ma escludendo questo l’immagine risulta piuttosto veritiera. Tuttavia, anche se non c’è nulla di palesemente sbagliato negli occhi generati dall’AI, a volte possono sembrare “strani”.

Il motivo principale per cui alcuni di questi occhi non vengono percepiti come reali si riduce all’incredibile capacità del cervello umano di riconoscere i modelli. Nelle nostre interazioni con altre persone, vediamo veri occhi umani in ogni espressione, angolazione, illuminazione e variazione. Il nostro cervello è allenato da tutta la nostra esistenza a riconoscere immediatamente un’emozione espressa solo negli occhi. Anche se spesso non siamo consci di questo nostra percezione, sentiamo “a pelle” quando ciò che vediamo non si allinea con i dati presenti nel nostro cervello. Se anche qualcosa di piccolo è fuori posto, ce ne accorgiamo. L‘AI non è ancora in grado di replicare in modo coerente le sottigliezze degli occhi umani in un modo che li renda realistici.

Perché le immagini generate dall’AI sono così inquietanti

Adesso che abbiamo constatato che il nostro cervello è in grado di riconoscere, anche basandosi sull’istinto, un’immagine generata da una reale, la domanda è: perché alcune di queste immagini ci danno un senso di inquietudine?

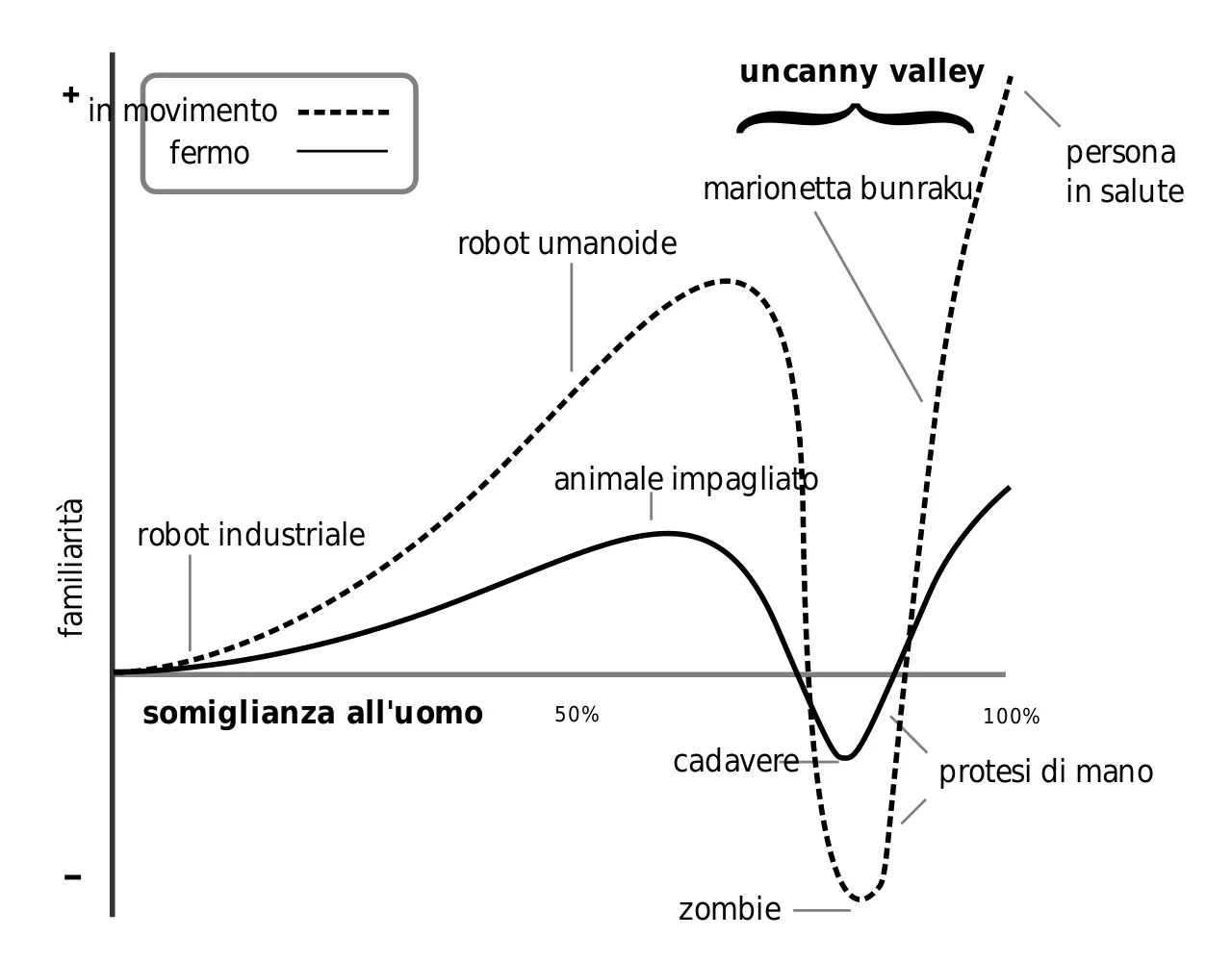

Un’ipotesi che spiega questo fenomeno è chiamata “Uncanny Valley“. Questo concetto esprime l’idea che quando riconosciamo che qualcosa di simile all’uomo non è in realtà umano, scatta un campanello d’allarme nella nostra mente. Spesso questo può accadere guardando robot umanoidi, bambole estremamente realistiche o scimmie con caratteristiche simili a quelle dell’uomo.

Il protagonista del film Ex Machina è inizialmente a disagio nei confronti del robot umanoide Ava, anche se poi finisce con l’innamorarsene – Fonte Super Guida TV

Questa teoria propone che esista una relazione proporzionale tra l’aspetto umano di qualcosa e la nostra affinità per esso (ovvero, quanto ci fa sentire a nostro agio) – fino a un certo limite. Una volta che un oggetto, un’immagine o una creatura raggiunge una soglia specifica di somiglianza umana, la nostra affinità precipita.

La “valle” creata da questa ripida caduta rappresenta il calo cognitivo nel vedere qualcosa che si avvicina alla somiglianza umana ma che riconosciamo come distintamente inumano.

Grafico che mostra l’andamento della Uncanny Valley – Fonte Wikipedia

Questo concetto è del tutto teorico ed ancora non dimostrato, ma è una spiegazione affascinante del perché alcune immagini di figure umane generate dall’AI possono farci sentire a disagio. Avere troppe dita o denti, o occhi inespressivi, può aumentare quella sensazione.

0 commenti